IT之家12月17日消息,在香港举办的全球图形学领域学术盛会SIGGRAPHAsia2025上,摩尔线程今日在3DGaussianSplattingReconstructionChallenge(3DGS重建挑战赛)中凭借自研技术LiteGS斩获银奖。

3DGaussianSplatting(3DGS,三维高斯溅射)是2023年提出的一项3D场景表示与渲染技术,以可参数化的3D高斯分布为核心,实现了画质、效率与资源占用之间的平衡。与传统NeRF相比,3DGS在保持逼真渲染质量的前提下,将渲染效率提升数百至上千倍,并在光线追踪、VR/AR实时渲染、多模态融合等方向展现出极强的适应性与扩展性。

本次竞赛为参赛团队设置的任务为:参赛者需在60秒内,基于主办方提供的真实终端视频序列(10–30秒)、存在误差的相机轨迹以及终端SLAM点云,在极短时间内完成完整的3DGS高质量重建。

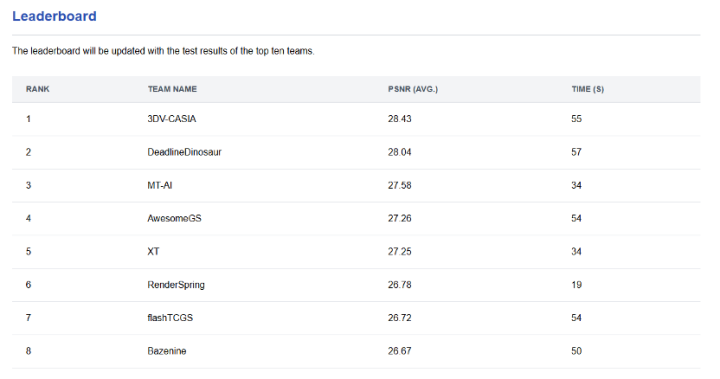

摩尔线程AI团队以参赛编号“MT-AI”进入决赛阶段,在重建精度与效率两项指标上取得亮眼表现:

平均PSNR:27.58(位列前三)

重建耗时:34秒(领先多数队伍)

凭借3DGS算法构建能力与软硬件协同优化优势,摩尔线程最终获得二等奖(银牌)的成绩。

作为一种新兴的场景表示与新视角合成技术,3DGS凭借高渲染质量与实时渲染速度,在计算机图形学与视觉领域实现了显著突破。该技术通过数以百万计的各向异性三维高斯基元来表示三维场景,以实现逼真的渲染效果,并在自动驾驶、虚拟现实、数字孪生等领域展现出巨大潜力。

然而,尽管3DGS的渲染速度极快,其训练过程却往往需要数十分钟甚至数小时,成为制约其广泛应用的主要瓶颈。现有优化方案往往仅从单一层面入手,难以系统性地解决训练过程中的性能制约。

为此,摩尔线程自主研发了3DGS基础库LiteGS,首次实现了从底层GPU系统、中层数据管理到高层算法设计的全链路协同优化:

在GPU系统层面,摩尔线程创新提出基于“OneWarpPerTile”原则的“Warp-BasedRaster”新范式,将梯度聚合简化为一次Warp内归约,并结合扫描线算法与混合精度策略,大幅降低梯度计算开销,同时实现高效的像素级统计能力;

在数据管理层,引入“聚类-剔除-压缩”流水线,借助Morton编码以极低开销对高斯基元进行动态空间重排,显著提升数据局部性,减少缓存失效与Warp分支;

在算法设计层,摒弃原有模糊的度量指标,采用更为鲁棒的像素不透明度梯度方差作为致密化的核心判据,精准识别欠拟合区域,其轻量化计算直接受益于底层光栅化器的高效统计支持。

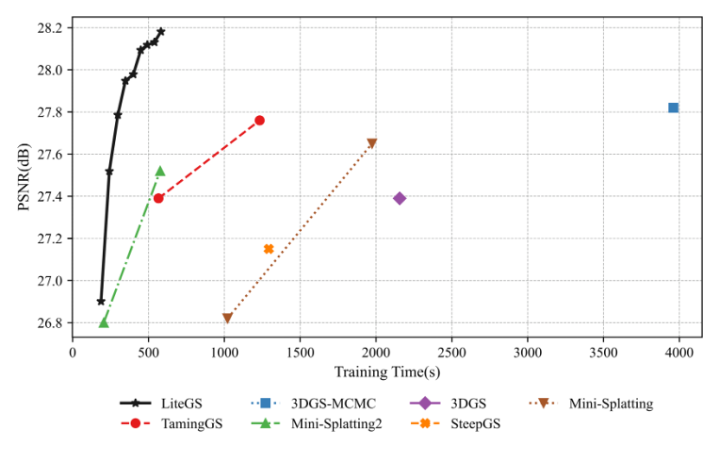

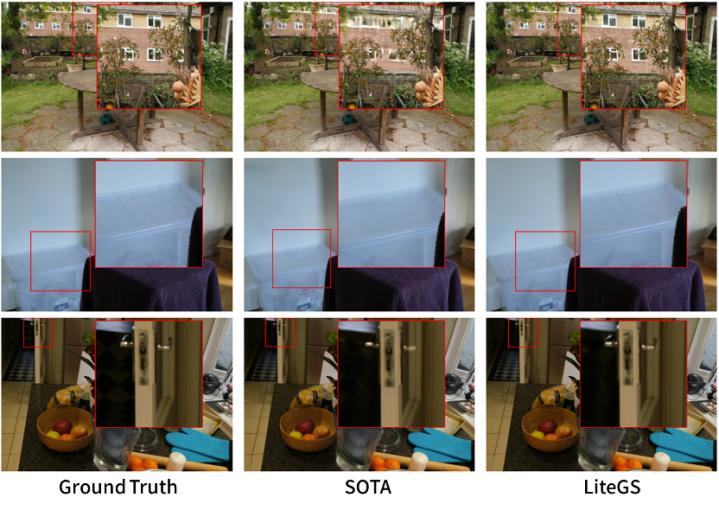

通过系统与算法的协同优化,LiteGS在训练效率与重建质量上均实现显著领先。

在达到与当前质量最优方案同等水平时,LiteGS可获得10.8倍的训练加速,且参数量减少一半以上;

在相同参数量下,LiteGS在PSNR指标上超出主流方案0.2–0.4dB,训练时间缩短3.8至7倍。

针对轻量化模型,LiteGS仅需原版3DGS约10%的训练时间与20%的参数量,即可实现同等质量。

目前,LiteGS已在GitHub平台全面开源,IT之家附开源地址如下:

2020炒股配资提示:文章来自网络,不代表本站观点。